uit onze archieven

Hoe queer is kunstmatige intelligentie?

AI in LHBTQAI

Kunstmatige intelligentie speelt een steeds grotere rol in ons leven, maar dat is niet zonder gevaar. Wetenschappers waarschuwen dat AI onvoldoende oog heeft voor de lhbtq-gemeenschap.

Kunstmatige intelligentie heeft de wereld in haar greep. Teksten, foto’s en zelfs muziek worden via AI (artificial intelligence) gemaakt. Zelfs de volgende profielfoto voor je datingapp laat je mogelijk door een AI genereren, omdat je daar net iets knapper op staat. Dit zijn voorbeelden van generatieve kunstmatige intelligentie: AI die binnen enkele seconden iets nieuws maakt aan de hand van simpele opdrachten.

ChatGPT is daar nu het meest populaire voorbeeld van. Deze chatbot van het bedrijf OpenAI heeft zich in een ongekend hoog tempo onmisbaar gemaakt. Binnen veertig dagen had de gratis dienst al tien miljoen dagelijkse gebruikers, die ChatGPT inzetten om onder andere teksten te schrijven, samenvattingen te maken en onderwerpen in begrijpelijke taal uit te leggen. Ter vergelijking: Instagram had bijna een jaar nodig om zoveel gebruikers bij elkaar te sprokkelen.

Generatieve kunstmatige intelligentie klinkt heel ingewikkeld, maar dat valt reuze mee. De makers van deze diensten voeren hun kunstmatige intelligentie een hoop data. Vervolgens kan de kunstmatige intelligentie zelfstandig in die data verbanden leggen. ChatGPT heeft bijvoorbeeld geleerd van heel veel artikelen en boeken, om vervolgens te snappen hoe een zin wordt opgebouwd.

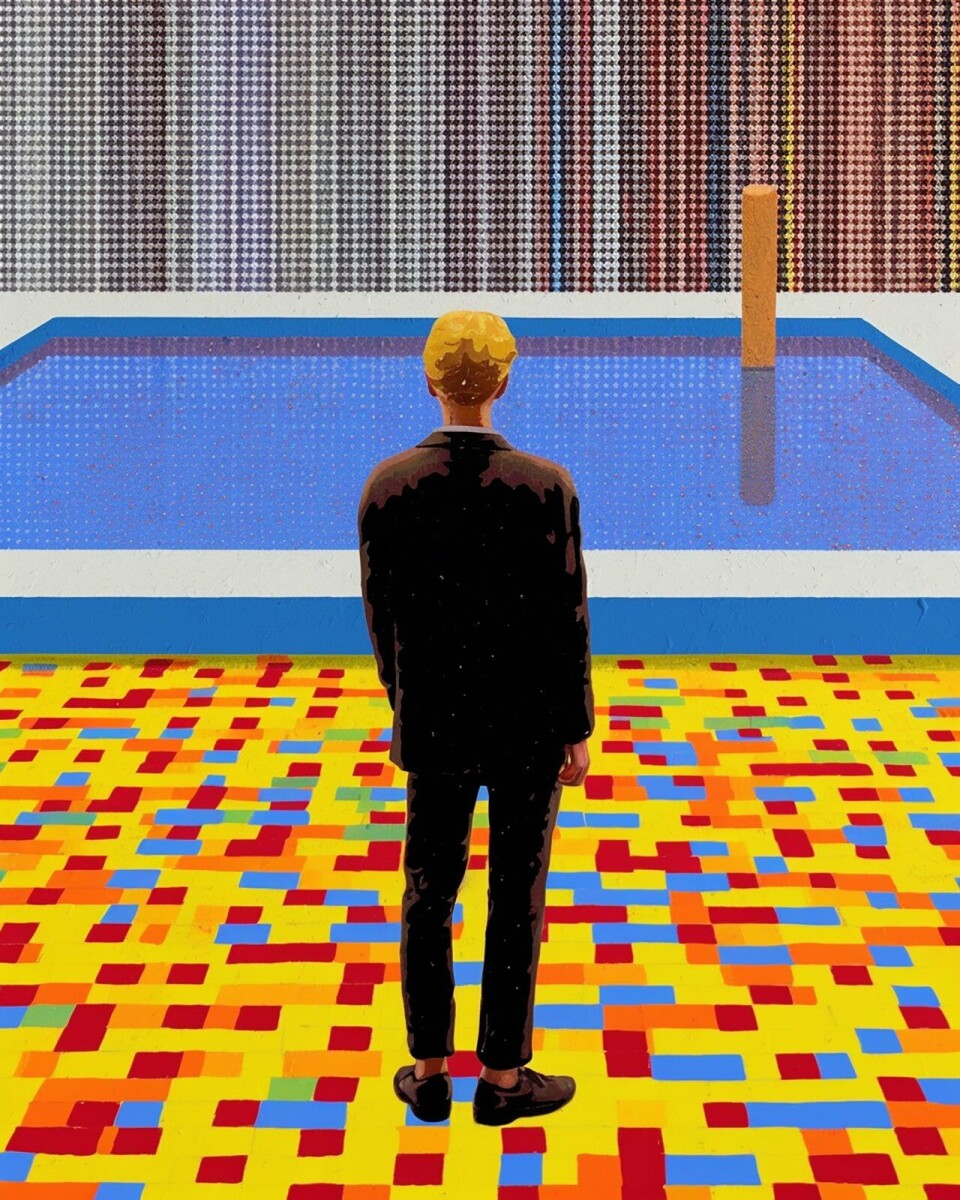

Iets soortgelijks gebeurt er bij het genereren van afbeeldingen, met populaire diensten zoals Midjourney en Dall-E. Deze diensten zijn een hoop foto’s, kunstwerken en tekeningen gevoed. Als je vervolgens de opdracht geeft om een nieuwe afbeelding te maken, is die altijd gebaseerd op die dataset. Ter frustratie van kunstenaars die duidelijk hun stijl in deze nieuwe afbeeldingen terugzien, maar daar geen credits voor krijgen.

weber merkte dat hen het woord dyke niet mocht gebruiken van chatgpt.

Levensgevaarlijke fouten

De diversiteit van de data waarmee een kunstmatige intelligentie is getraind, bepaalt hoe goed deze werkt. Als een tool voor gezichtsherkenning bijvoorbeeld voornamelijk wordt getraind met witte gezichten, zal deze zwarte gezichten met moeite herkennen. Bij nieuwe vormen van kunstmatige intelligentie kan op een vergelijkbare manier de lhbtq-gemeenschap in gevaar komen, waarschuwen wetenschappers.

“Bij het maken van machines wordt er heel binair gedacht. Het werkt of het werkt niet”, vertelt Eduard Fosch-Villaronga, professor aan Universiteit Leiden gespecialiseerd in kunstmatige intelligentie en de wet. “Het licht is aan of het licht is uit. Dat soort denken in dualisme zorgt ervoor dat er heel weinig ruimte is voor een spectrum vol verschillen.” Een van de meest duidelijke voorbeelden daarvan zijn volgens Fosch-Villaronga systemen die gender van mensen classificeren. “Gebruikelijk wordt dan de parameter sekse gebruikt in een binaire vorm: man of vrouw, maar dan mis je de interseksegemeenschap. Daarnaast zijn gender en sekse niet hetzelfde. Gender is inherent subjectief voor de persoon en dat is niet altijd te koppelen aan uiterlijke kenmerken. Dan maakt een machine fouten.”

Steeds vaker komt er kunstmatige intelligentie kijken bij momenten die levensbepalend zijn. Een recent pijnlijk voorbeeld daarvan is de Toeslagenaffaire. Ook in de gezondheidszorg wordt AI gebruikt om diagnoses te stellen en behandelplannen te bepalen. Als jouw genderidentiteit verandert, kan zo’n systeem daar moeite mee hebben. “Als dat in medische context gebeurt, kan het misgenderen van iemand leiden tot een verkeerde diagnose en daadwerkelijk de veiligheid van mensen in gevaar brengen”, stelt Fosch-Villaronga.

“Seksuele- en genderidentiteiten zijn inherent fluïde”, beaamt Sabine Weber van Queer in AI, een verbond van queer wetenschappers dat zich inzet om meer bewustzijn te creëren over deze problemen. “Als we praten over queer als een politieke term, dan is het belangrijk om onszelf als veelzijdige wezens te zien die zichzelf in verschillende situaties anders voorstellen. Dat is iets wat volledig genegeerd wordt door deze systemen.”

Het gemiddelde van het gemiddelde

Een tweede probleem is dat queer mensen ondergerepresenteerd zijn in de datasets achter kunstmatige intelligenties. “Hoe zo’n model werkt is dat het statistische patronen oppikt en daardoor leert wat de meerderheid doet, waardoor bestaande vooroordelen worden versterkt”, stelt Weber. “Zo zal een systeem dat moet bepalen of tweets negatief of positief zijn, queertaal waarschijnlijk eerder associëren met negatieve dingen.”

Weber merkte dat hen het woord dyke niet mocht gebruiken van ChatGPT. Dit woord werd voornamelijk vroeger gebruikt als een homofobe term richting lesbische vrouwen, maar wordt nu ook door de lesbische gemeenschap omarmd als geuzennaam. Later gebruikte ChatGPT in het gesprek met Weber wel ‘dyke’ in een tekst. “De stemmen van de queer gemeenschap zijn in de loop van de geschiedenis vaak gecontroleerd en tot zwijgen gebracht, en dit is weer een nieuwe frontlinie”, schrijft Weber in een blog op de website van Queer in AI getiteld ‘ChatGPT calls me a dyke’.

Dat deze systemen vanuit de norm denken wordt heel snel duidelijk als je AI-programma Midjourney vraagt om een afbeelding van een mens te maken. Je krijgt dan standaard een plaatje van een wit persoon. Totdat je in de opdracht heel specifiek vraagt om een andere huidskleur dan wit. Dat komt doordat de afbeeldingen waarmee de kunstmatige intelligentie is getraind voornamelijk witte mensen bevatten.

“mensen die al gemarginaliseerd zijn, zullen meer gemarginaliseerd worden”

Ook wordt AI nu vaker gebruikt om tv-series, boeken en films te schrijven, maar het resultaat is niet best. “Systemen die getraind zijn op de mainstream zijn zo ongelooflijk saai”, stelt Weber, die in het verleden literatuur heeft gestudeerd. “Ze zullen nooit iets maken wat echt ongewoon of nieuw is. Je krijgt het gemiddelde van het gemiddelde van het gemiddelde.”

Queer AI

Queer artiest Emily Martinez maakte als tegenreactie Queer AI, met datasets compleet bestaande uit erotische literatuur en feministische en queer theory. De queer chatbots zijn inmiddels offline, maar enkele resultaten zijn nog terug te lezen in de verzameling Ultimate Fantasy. Waaronder gedichten, zoals ‘The Love Object’, met strofes zoals:

We go to a gay bar.

And I fall in love.

Orgasm after we have sex.

Orgasm after kissing.

Orgasm after I fall in love.

En later:

For three days I could tell you we’re falling in love, but the love never stopped.

My love never stopped either.

My skin crawled all over.

When I finally did go to the hospital I told them I had AIDS.

You still love me, love.

And I was in the emergency room.

Het zijn teksten die een ‘hetero’ ChatGPT nooit zou schrijven

Mogelijke oplossingen

In gesprek met ChatGPT duurt het niet lang tot de chatbot de eerder genoemde problemen ruimhartig toegeeft: “Het is waar dat de dataset waarop ik ben getraind, net als elke dataset, beperkingen heeft en niet perfect is.” En “Het is belangrijk om op te merken dat het niet alleen de verantwoordelijkheid is van de dataset, maar ook van de programmeurs om ervoor te zorgen dat mijn antwoorden inclusief zijn en geen vooroordelen bevatten. Er zijn momenteel veel inspanningen gaande om AI-systemen te verbeteren en te zorgen voor meer inclusiviteit en diversiteit in training datasets, en ik hoop dat deze inspanningen zullen blijven toenemen en verbeteren naarmate de technologie zich ontwikkelt.”

als een tool voor gezichtsherkenning voornamelijk wordt getraind met witte gezichten, zal deze zwarte gezichten met moeite herkennen.

Fosch-Villaronga en ChatGPT zijn het hier met elkaar eens. Een deel van de oplossing zou volgens de professor al in de basis moeten liggen: bij de teams die deze technologieën maken. “Hoe divers zijn ze? Hoeveel moeite wordt er gedaan om ervoor te zorgen dat diversiteit en inclusie worden meegenomen?”

Daarnaast is het een flink irritatiepunt voor wetenschappers die zich met dit onderwerp bezighouden, dat de datasets achter deze kunstmatige intelligenties niet openbaar zijn en daardoor alleen door gebruik getest kunnen worden. Onbegonnen werk, stelt Fosch-Villaronga. “We hebben bijvoorbeeld geen leger aan dragqueens die controleren of deze systemen hen misrepresenteren of niet.”

De professor refereert naar een onderzoek uit 2021 van de Universiteit van São Paulo, waarin kunstmatige intelligentie werd gebruikt om de ‘giftigheid’ van tweets te onderzoeken. Veel tweets van dragqueens werden als giftig gemarkeerd, omdat de context niet begrepen werd. Als dragqueens elkaar bijvoorbeeld ‘bitch’ noemen, is dat meestal positief bedoeld.

Voor je het weet, is het te laat

“Deze systemen worden op de markt gezet in de veronderstelling dat ze veilig zijn, maar daarna leren ze verder van interactie met gebruikers”, vertelt Fosch-Villaronga. Daardoor wordt deze kunstmatige intelligenties steeds meer data gevoerd, waar nieuwe verbanden in gelegd kunnen worden. “Dat kan ook gevolgen hebben.”

Het meest opvallende voorbeeld daarvan is chatbot Tay van Microsoft en Open AI uit 2016, te zien als een vroege voorloper van ChatGPT. Het idee was dat deze chatbot zou leren van tweets en de interactie met gebruikers op Twitter. Het duurde niet lang tot Tay racistische en transfobe uitspraken deed. Binnen een dag moest de bot offline worden gehaald.

Maar terwijl Tay openbaar over de grens ging, worden de beslissingen van andere kunstmatige intelligenties meestal in het duister gemaakt. Fosch-Villaronga is ongerust: “Dit soort problemen blijft vaak onzichtbaar tot het te laat is. Dan krijgt iemand wellicht geen lening, geen beurs of geen promotie. Er zijn intrinsieke gevaren rond het maken van beslissingen gebaseerd op deze systemen, die jou in een nadelige positie kunnen plaatsen omdat je onderdeel bent van de gemeenschap.” Weber beaamt deze boodschap: “Mensen die al gemarginaliseerd zijn zullen meer gemarginaliseerd worden. Dat is hoe deze systemen werken.”

De illustraties op deze pagina’s zijn gemaakt met AI-programma Midjourney. We betaalden beeldmakers Dario & Misja om de illustraties te genereren. De prompts die zij daarvoor gebruikten vind je in bijschriften.